-

데이터 변경이력

데이터 변경이력 버전 일자 변경내용 비고 1.1 2024-04-09 데이터 최종 개방 1.0 2023-06-28 데이터 개방(Beta Version) 데이터 히스토리

데이터 히스토리 일자 변경내용 비고 2024-06-13 데이터설명서, 담당자 정보 수정 2024-01-12 산출물 전체 공개 2024-01-05 Sample 파일 공개 2023-12-01 구축업체정보 수정 2023-11-24 구축업체정보 수정 소개

- 한국어 철자 및 문법, 음성인식 후처리용 병렬 말뭉치, 과교정 검증 데이터 구축

구축목적

- 자연어 이해 및 자연어 생성에 대한 연구 및 개발한 언어모델 평가 등에 활용 - 다양한 산업에서 민원·응대 등에 활용되는 챗봇, AI 비서와 같은 언어모델 평가 등에 활용

-

메타데이터 구조표 데이터 영역 한국어 데이터 유형 텍스트 데이터 형식 JSON 데이터 출처 신규 제작 라벨링 유형 분류, 교정 라벨링 형식 JSON 데이터 활용 서비스 한국어 맞춤법 교정기, 음성인식 데이터 구축년도/

데이터 구축량2022년/2,201,601건 -

데이터 통계

데이터 구축 규모

데이터 구축 규모 데이터 종류 규모 텍스트 데이터 2,201,601건 데이터 분포

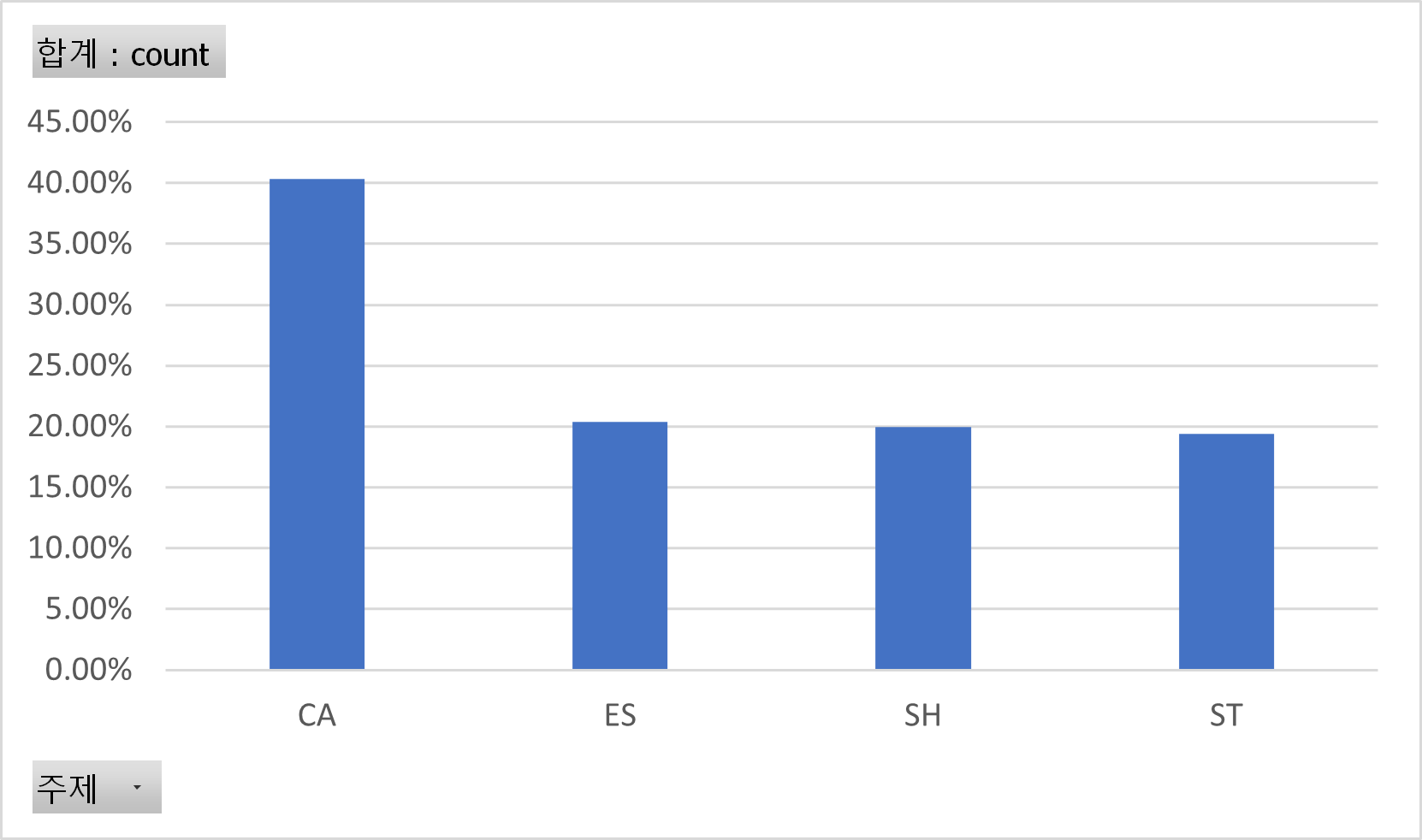

○ 데이터셋별 분포

데이터 분포○ 데이터셋별 분포 데이터셋명 수량 051-1 한국어 철자 및 문법 데이터 1,000,001 051-2 음성인식 후처리용 병렬 말뭉치 1,001,600 051-3 과교정 검증 데이터 200,000 총 2,201,601 ○ 주제별 분포

데이터 분포○ 주제별 분포 주제 비율 CA 40.31% ES 20.36% SH 19.93% ST 19.40% 총 100%

-

-

AI 모델 상세 설명서 다운로드

AI 모델 상세 설명서 다운로드 AI 모델 다운로드모델 학습

○ 한국어 철자 및 맞춤법 교정 모델한국어 철자 및 맞춤법 교정 데이터를 이용하여 Transformer 모델을 학습한 모델. 한국어 철자 및 맞춤법을 수행할 수 있음.

예시)

입력: 고마워 맛집, 일정 갈만한곳도 추천좀 해줘.

출력: 고마워. 맛집, 일정, 갈만한 곳도 추천 좀 해줘.○ 음성인식 후처리 교정 모델음성인식 후 제대로 생성되지 않은 텍스트를 수정하는 모델. 음성인식 후처리기용 병렬 데이터를 이용하여 Transformer 모델을 학습하였음.

예시)입력: 혹시 아크릴 소재로 된 크롭자켓 말하는 거야

출력: 혹시 아크릴 소재로 된 크롭 재킷 말하는 거야?○ 한국어 철자 및 맞춤법 교정 분류 모델한국어 문장에서 각 토큰마다 특정한 교정 오류의 존재 여부를 판독하는 모델. 띄어쓰기 오류, 맞춤법 및 문법 오류, 변환 오류, 기타 오류 및 오류없음 0으로 분류함.

예시)입력: 밤바다의정취도 좋았고, 특히 맛잇는 음식들이 많았어.

출력: 0 0 0 0 0 0○ 음성인식 후처리 교정 분류 모델음성인식 후 인식된 문장의 오류를 인식해서 분류하는 모델.오인식, 변환 오류, 맞춤법 및 문법 오류, 기타 오류, 띄어쓰기 오류 그리고 오류없음 0으로 분류함.예시)입력: 다크브라운 이거 루즈핏 야 너한테 잘어울릴 듯 한데출력: 0 0

○ 과교정 교정 분류 모델한국어 문장에서 각 토큰마다 과교정 오류를 인식해서 분류하는 모델.교체, 삭제

- , 추가, 띄어쓰기, 구두점 부착, 외국어/숫자 변환, 철자/문법 그리고 오류없음 0으로 분류함.예시)입력: 필리피노 마켓이 저렴해서 한국 돈으로 얼마 안해 색깔 한식 달러 정도 했나출력: 0 0 0 0 0 0 0 0 0

- , 추가, 띄어쓰기, 구두점 부착, 외국어/숫자 변환, 철자/문법 그리고 오류없음 0으로 분류함.예시)입력: 필리피노 마켓이 저렴해서 한국 돈으로 얼마 안해 색깔 한식 달러 정도 했나출력: 0 0 0 0 0 0 0 0 0

-

데이터 성능 점수

측정값 (%)기준값 (%)데이터 성능 지표

데이터 성능 지표 번호 측정항목 AI TASK 학습모델 지표명 기준값 점수 측정값 점수 1 한국어 철자 및 맞춤법 교정 분류 정확도 Text Classification COMET22 + COMET-KIWI Accuracy 50 % 84 % 2 음성인식 후처리기용 병렬 데이터 교정 분류 정확도 Text Classification COMET22 + COMET-KIWI Accuracy 50 % 91 % 3 자연어 분석 후처리용 과교정 검증데이터 교정 분류 정확도 Text Classification COMET22 + COMET-KIWI Accuracy 50 % 98 % 4 한국어 철자 및 맞춤법 교정 정확도 Machine Translation Transformer enc-dec + Fairseq BLEU 0.8 점 0.924 점 5 음성인식 후처리기용 병렬 데이터 교정 정확도 Machine Translation Transformer enc-dec + Fairseq BLEU 0.6261 점 0.6751 점

※ 데이터 성능 지표가 여러 개일 경우 각 항목을 클릭하면 해당 지표의 값이 그래프에 표기됩니다.

※ AI모델 평가 지표에 따라 측정값의 범위, 판단 기준이 달라질 수 있습니다. (ex. 오류율의 경우, 낮을수록 좋은 성능을 내는 것으로 평가됩니다)

-

설명서 및 활용가이드 다운로드

데이터 설명서 다운로드 구축활용가이드 다운로드데이터 포맷 대표도면 및 JSON 형식

{ "id": "100008-1-1-1",

"fileName": "TX_CA_1_100008-1-1-1",

"dataSet": "한국어 철자 및 맞춤법 교정용 병렬 데이터",

"domain": "CA",

"ko": "지금까지 다녀 본 여행지 중 좋았던 곳 추천해줘.",

"corrected": "지금까지 다녀 본 여행지 중 좋았던 곳 추천해 줘.",

"error": [

{

"errorType": "spac",

"startPoint": 22,

"endPoint": 27

}

]

}데이터 구성

데이터 구성 데이터 유형 구분 설명 원천데이터 주제 문화예술(CA), 경제사회(ES), 생활건강(SH), 과학기술(ST) 라벨링데이터 오류 태깅 맞춤법/음성인식/과교정 오류 span 및 유형 교정문 오류 교정문 (과교정 데이터 제외) 어노테이션 포맷

○ 한국어 철자 및 문법 데이터

어노테이션 포맷○ 한국어 철자 및 문법 데이터 No 항목 타입 필수여부 한글명 영문명 1 데이터 아이디 id String Y 2 파일이름 fileName String Y 3 데이터셋 dataSet String Y 4 도메인 domain String Y 5 원본 문장 ko String Y 6 교정 문장(인간) corrected String Y 7 오류 유형 태깅 error Array Y 7-1 오류 유형 error[].errorType String Y 7-2 오류 시작위치 error[].startPoint Number Y 7-3 오류 끝 위치 error[].endPoint Number Y ○ 음성인식 후처리용 병렬 말뭉치

어노테이션 포맷○ 음성인식 후처리용 병렬 말뭉치 No 항목 타입 필수여부 한글명 영문명 1 데이터 아이디 id String Y 2 파일이름 fileName String Y 3 데이터셋 dataSet String Y 4 도메인 domain String Y 5 인식기 출처 recSource String Y 6 STT 인식 문장 ko String N 7 교정 문장(인간) corrected String Y 8 오류 유형 태깅 error Array Y 8-1 오류 유형 error[].errorType String Y 8-2 오류 시작위치 error[].startPoint Number Y 8-3 오류 끝 위치 error[].endPoint Number Y ○ 과교정 검증 데이터

어노테이션 포맷○ 과교정 검증 데이터 No 항목 타입 필수여부 한글명 영문명 1 데이터 아이디 id String Y 2 파일이름 fileName String Y 3 데이터셋 dataSet String Y 4 도메인 domain String Y 5 원본/STT 인식 문장 ko String Y 6 교정 문장(인간) corrected String Y 7 문법교정기 결과물 autoproof String Y 8 과교정 태깅 excess Array Y 8-1 오류 유형 excess[].errorType String Y 8-2 오류 시작위치 excess[].startPoint Number Y 8-3 오류 끝 위치 excess[].endPoint Number Y 실제 예시

{ "id": "100008-1-1-1", { "id": "100007-364-5-24", { "id": "100007-153-11-34", "fileName": "TX_CA_1_100008-1-1-1", "fileName": "TX_ES_2_100007-364-5-24", "fileName": "TX_CA_3_100007-153-11-34", "dataSet": "한국어 철자 및 맞춤법 교정용 병렬 데이터", "dataSet": "음성인식 후처리용 교정 데이터", "dataSet": "과교정 검증 데이터", "domain": "CA", "domain": "ES", "domain": "CA", "ko": "지금까지 다녀 본 여행지 중 좋았던 곳 추천해줘.", "recSource": "sr_naver", "ko": "요새 코로나 해외 여행도 못 가는데 어떻게", "corrected": "지금까지 다녀 본 여행지 중 좋았던 곳 추천해 줘.", "ko": "야시 패션에서 한약 그 시간에 자소서나 더 쓰지 않는다는 그래도 거기 스터디 좋아 엔드게임 엔드 오빠 멋있지 않냐", "corrected": "요새 코로나로 해외 여행도 못 가는데, 어떻게 지내?", "error": [ "corrected": "야 아직도 에스엔에스 하냐 그 시간에 자소서나 더 쓰지 암튼 나는 그래도 거기 스터디 좋아 $name$오빠 멋있지 않냐?", "autoproof": "요새 코로나로 해외여행도 못 가는데, 어떻게 지내?", { "error": [ "excess": [ "errorType": "spac", { { "startPoint": 22, "errorType": "mis_recog", "errorType": "over_spacing", "endPoint": 27 "startPoint": 0, "startPoint": 8, } "endPoint": 2 "endPoint": 13 ] }, } } { ] "errorType": "mis_recog", } "startPoint": 3, "endPoint": 7 }, { "errorType": "mis_recog", "startPoint": 8, "endPoint": 10 }, { "errorType": "mis_recog", "startPoint": 27, "endPoint": 31 }, { "errorType": "mis_recog", "startPoint": 46, "endPoint": 50 } ] } -

데이터셋 구축 담당자

수행기관(주관) : 한국외국어대학교

수행기관(주관) 책임자명 전화번호 대표이메일 담당업무 신선호 02-2173-2493 [email protected] 데이터 설계 및 원천데이터 가공, 라벨링데이터 검수 수행기관(참여)

수행기관(참여) 기관명 담당업무 엠브레인퍼블릭 원시데이터 수집 및 정제 카카오엔터프라이즈 AI 학습 모델링 ㈜오피니언라이브 저작도구 개발 및 운영, 품질관리 데이터 관련 문의처

데이터 관련 문의처 담당자명 전화번호 이메일 신선호 02-2173-2493 [email protected]

-

인터넷과 물리적으로 분리된 온라인·오프라인 공간으로 의료 데이터를 포함하여 보안 조치가 요구되는 데이터를 다운로드 없이 접근하고 분석 가능

* 온라인 안심존 : 보안이 보장된 온라인 네트워크를 통해 집, 연구실, 사무실 등 어디서나 접속하여 데이터에 접근하고 분석

* 오프라인 안심존 : 추가적인 보안이 필요한 데이터를 대상으로 지정된 물리적 공간에서만 접속하여 데이터에 접근하고 분석 -

- AI 허브 접속

신청자 - 안심존

사용신청신청자신청서류 제출* - 심사구축기관

- 승인구축기관

- 데이터 분석 활용신청자

- 분석모델반출신청자

- AI 허브 접속

-

1. 기관생명윤리위원회(IRB) 심의 결과 통지서 [IRB 알아보기] [공용IRB 심의신청 가이드라인]

2. 기관생명윤리위원회(IRB) 승인된 연구계획서

3. 신청자 소속 증빙 서류 (재직증명서, 재학증명서, 근로계약서 등 택1)

4. 안심존 이용 신청서 [다운로드]

5. 보안서약서 [다운로드]

※ 상기 신청서 및 첨부 서류를 완비한 후 신청을 진행하셔야 정상적으로 절차가 이루어집니다. -

신청 및 이용관련 문의는 [email protected] 또는 02-525-7708, 7709로 문의

데이터셋 다운로드 승인이 완료 된 후 API 다운로드 서비스를 이용하실 수 있습니다.

API 다운로드 파일은 분할 압축되어 다운로드 됩니다. 분할 압축 해제를 위해서는 분할 압축 파일들의 병합이 필요하며 리눅스 명령어 사용이 필요합니다.

리눅스 OS 계열에서 다운로드 받으시길 권장하며 윈도우에서 파일 다운로드 시 wsl(리눅스용 윈도우 하위 시스템) 설치가 필요합니다.

※ 파일 병합 리눅스 명령어

find "폴더경로" -name "파일명.zip.part*" -print0 | sort -zt'.' -k2V | xargs -0 cat > "파일명.zip"

- 해당 명령어 실행 시, 실행 경로 위치에 병합 압축 파일이 생성됩니다.

- 병합된 파일 용량이 0일 경우, 제대로 병합이 되지 않은 상태이니 "폴더경로"가 제대로 입력되었는지 확인 부탁드립니다.

※ 데이터셋 소개 페이지에서 다운로드 버튼 클릭하여 승인이 필요합니다.